机器学习算法-图解说明(上)

机器学习算法-图解说明(上)

提示

本文主要是介绍 机器学习算法-图解说明(上) 。

人工智能常用的十种算法(上)

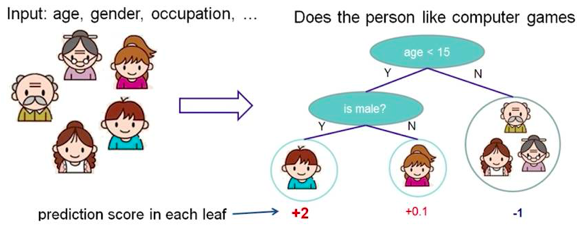

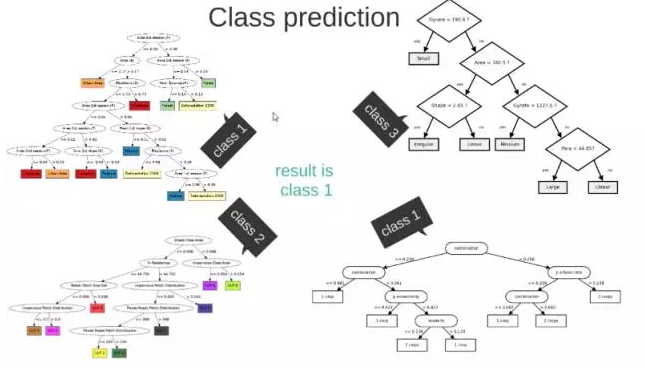

1. 决策树

根据一些 feature 进行分类,每个节点提一个问题,通过判断,将数据分为两类,再继续提问。这些问题是根据已有数据学习出来的,再投入新数据的时候,就可以根据这棵树上的问题,将数据划分到合适的叶子上。

如果你觉得这篇文章看起来稍微还有些吃力,或者想要更系统地学习人工智能,那么推荐你去看床长人工智能教程。非常棒的大神之作,教程不仅通俗易懂,而且很风趣幽默。点击这里可以查看教程。

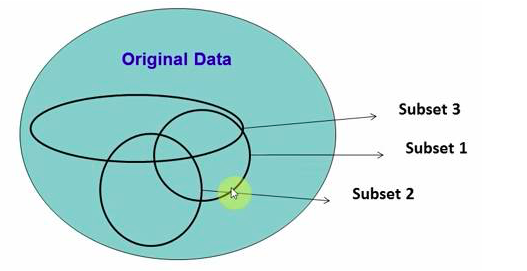

2. 随机森林

在源数据中随机选取数据,组成几个子集

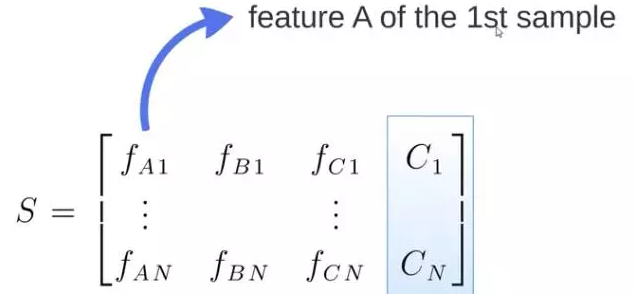

S 矩阵是源数据,有 1-N 条数据,A B C 是feature,最后一列C是类别

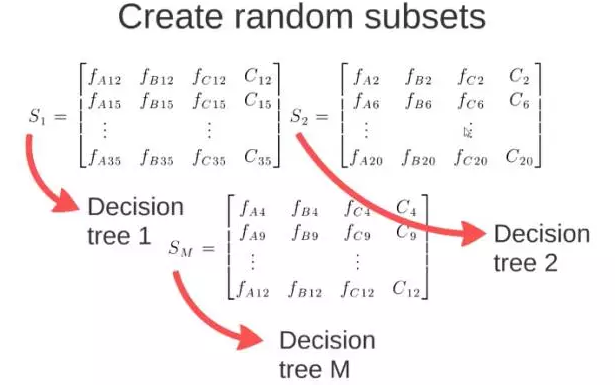

由 S 随机生成 M 个子矩阵

这 M 个子集得到 M 个决策树

将新数据投入到这 M 个树中,得到 M 个分类结果,计数看预测成哪一类的数目最多,就将此类别作为最后的预测结果

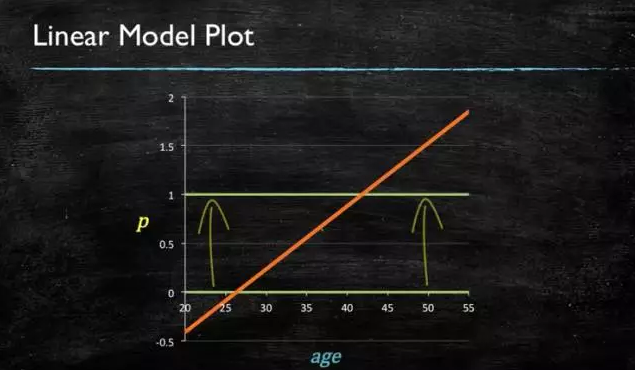

3. 逻辑回归

当预测目标是概率这样的,值域需要满足大于等于0,小于等于1的,这个时候单纯的线性模型是做不到的,因为在定义域不在某个范围之内时,值域也超出了规定区间。

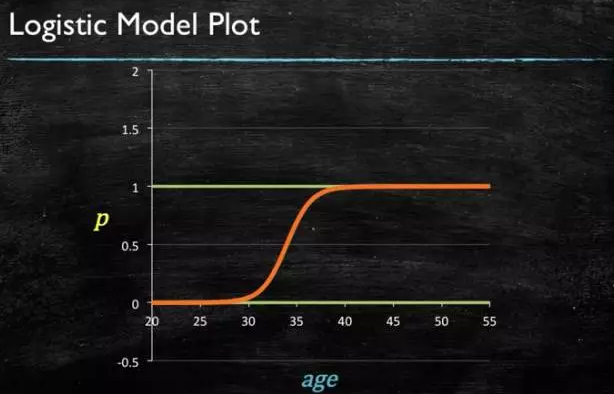

所以此时需要这样的形状的模型会比较好

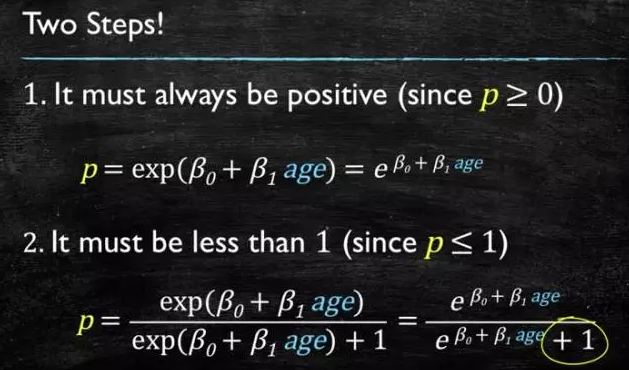

那么怎么得到这样的模型呢?

这个模型需要满足两个条件 大于等于0,小于等于1 大于等于0 的模型可以选择 绝对值,平方值,这里用 指数函数,一定大于0 小于等于1 用除法,分子是自己,分母是自身加上1,那一定是小于1的了

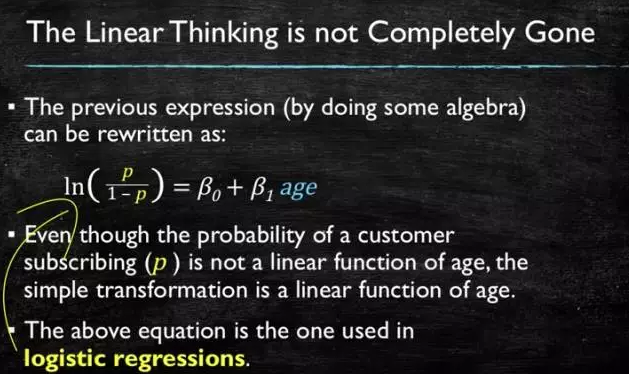

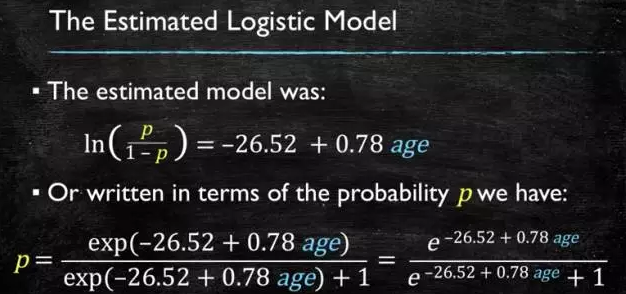

再做一下变形,就得到了 logistic regression 模型

通过源数据计算可以得到相应的系数了

最后得到 logistic 的图形

4. SVM

support vector machine

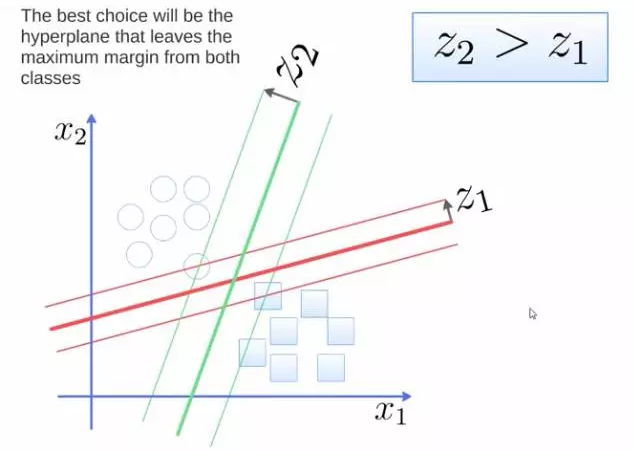

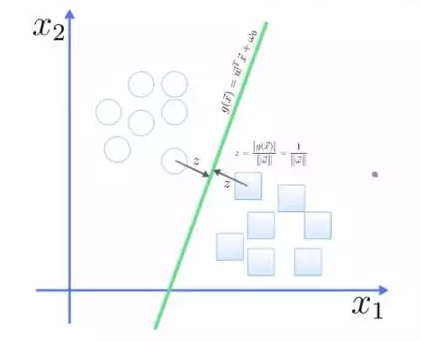

要将两类分开,想要得到一个超平面,最优的超平面是到两类的 margin 达到最大,margin就是超平面与离它最近一点的距离,如下图,Z2>Z1,所以绿色的超平面比较好

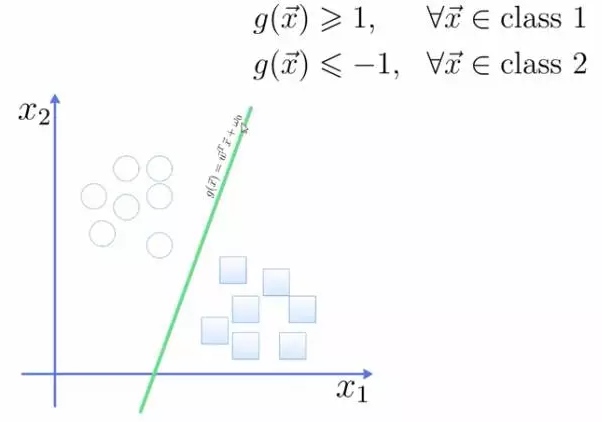

将这个超平面表示成一个线性方程,在线上方的一类,都大于等于1,另一类小于等于-1

点到面的距离根据图中的公式计算

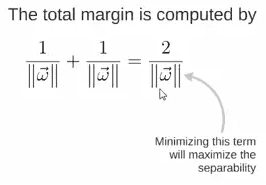

所以得到 total margin 的表达式如下,目标是最大化这个 margin,就需要最小化分母,于是变成了一个优化问题

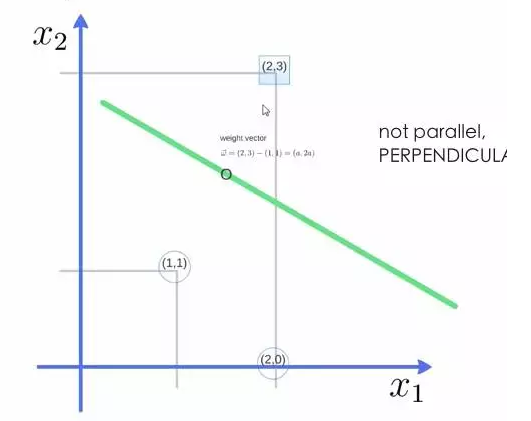

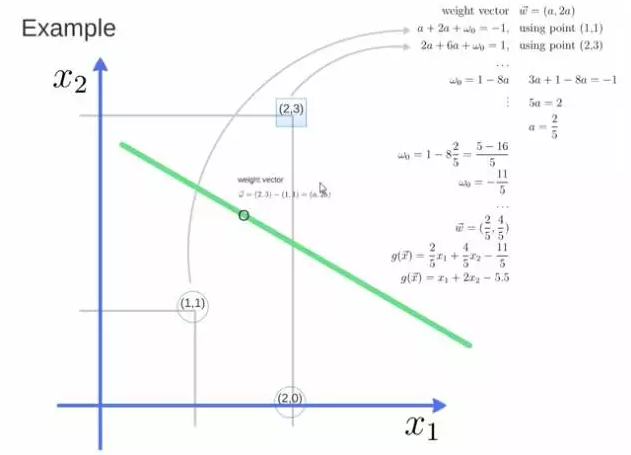

举个栗子,三个点,找到最优的超平面,定义了 weight vector=(2,3)-(1,1)

得到 weight vector 为(a,2a),将两个点代入方程,代入(2,3)另其值=1,代入(1,1)另其值=-1,求解出 a 和 截矩 w0 的值,进而得到超平面的表达式。

a 求出来后,代入(a,2a)得到的就是 support vector

a 和 w0 代入超平面的方程就是 support vector machine

转载:https://blog.csdn.net/qq_45067177/article/details/90411885

参考文章

- https://www.cnblogs.com/nangua19/p/10938152.html